部署、升级和监控应用程序

部署应用程序有一个集群资源管理器,比如standalone模式下的Spark集群,Yarn模式下的Yarn集群等。打包应用程序为一个jar包,课程中一直都有演示。为executor配置充足的内存,因为Receiver接受到的数据,是要存储在Ex...

Checkpoint机制

概述每一个Spark Streaming应用,正常来说,都是要7 * 24小时运转的,这就是实时计算程序的特点。因为要持续不断的对数据进行计算。因此,对实时计算应用的要求,应该是必须要能够对与应用程序逻辑无关的失败,进行...

缓存、持久化机制

与RDD类似,Spark Streaming也可以让开发人员手动控制,将数据流中的数据持久化到内存中。对DStream调用persist()方法,就可以让Spark Streaming自动将该数据流中的所有产生的RDD,都持久化到内存中。如果要对一个DS...

Stream的output操作以及foreachRDD详解

output操作OutputMeaningprint打印每个batch中的前10个元素,主要用于测试,或者是不需要执行什么output操作时,用于简单触发一下job。saveAsTextFile(prefix, [suffix])将每个batch的数据保存到文件中。每个batch的...

window滑动窗口以及热点搜索词滑动统计案例实战

Spark Streaming提供了滑动窗口操作的支持,从而让我们可以对一个滑动窗口内的数据执行计算操作。每次掉落在窗口内的RDD的数据,会被聚合起来执行计算操作,然后生成的RDD,会作为window DStream的一个RDD。比如下图...

transform以及广告计费日志实时黑名单过滤案例实战

transform操作,应用在DStream上时,可以用于执行任意的RDD到RDD的转换操作。它可以用于实现,DStream API中所没有提供的操作。比如说,DStream API中,并没有提供将一个DStream中的每个batch,与一个特定的RDD进行j...

updateStateByKey以及基于缓存的实时wordcount程序

updateStateByKey操作,可以让我们为每个key维护一份state,并持续不断的更新该state。首先,要定义一个state,可以是任意的数据类型;其次,要定义state更新函数——指定一个函数如何使用之前的state和新值来更新stat...

DStream的transformation操作概述

TransformationMeaningmap对传入的每个元素,返回一个新的元素flatMap对传入的每个元素,返回一个或多个元素filter对传入的元素返回true或false,返回的false的元素被过滤掉union将两个DStream进行合并count返回元素...

大商创如何重置或修改商家店铺登录密码?

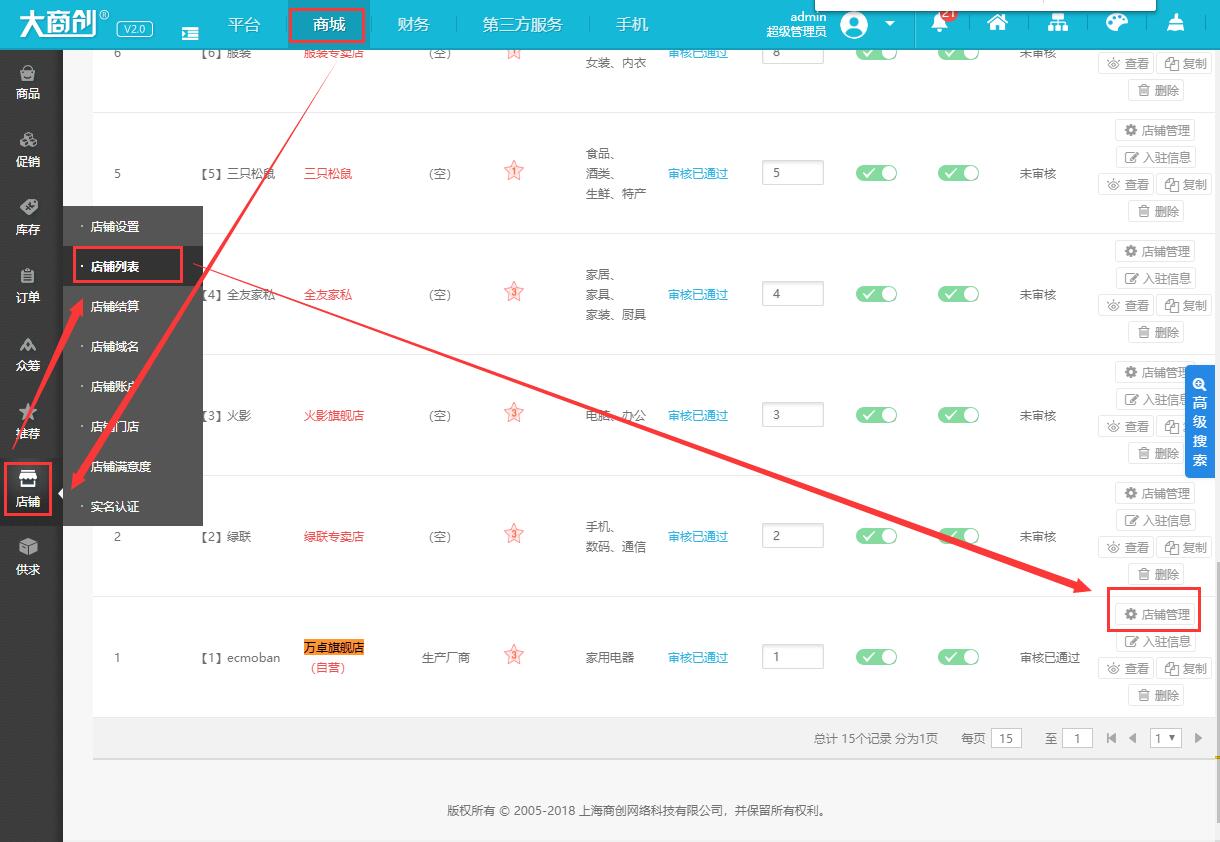

本文介绍如何修改或重置大商创商家的登录密码,实际运营过程中,忘记商家后台的用户名和密码也是非常常见的,具体步骤如下1、首先,登录大商创的后台,依次点击【商城】→【店铺】→【店铺列表】,我们以修改“万卓旗舰...

大商创如何重置或修改会员密码?

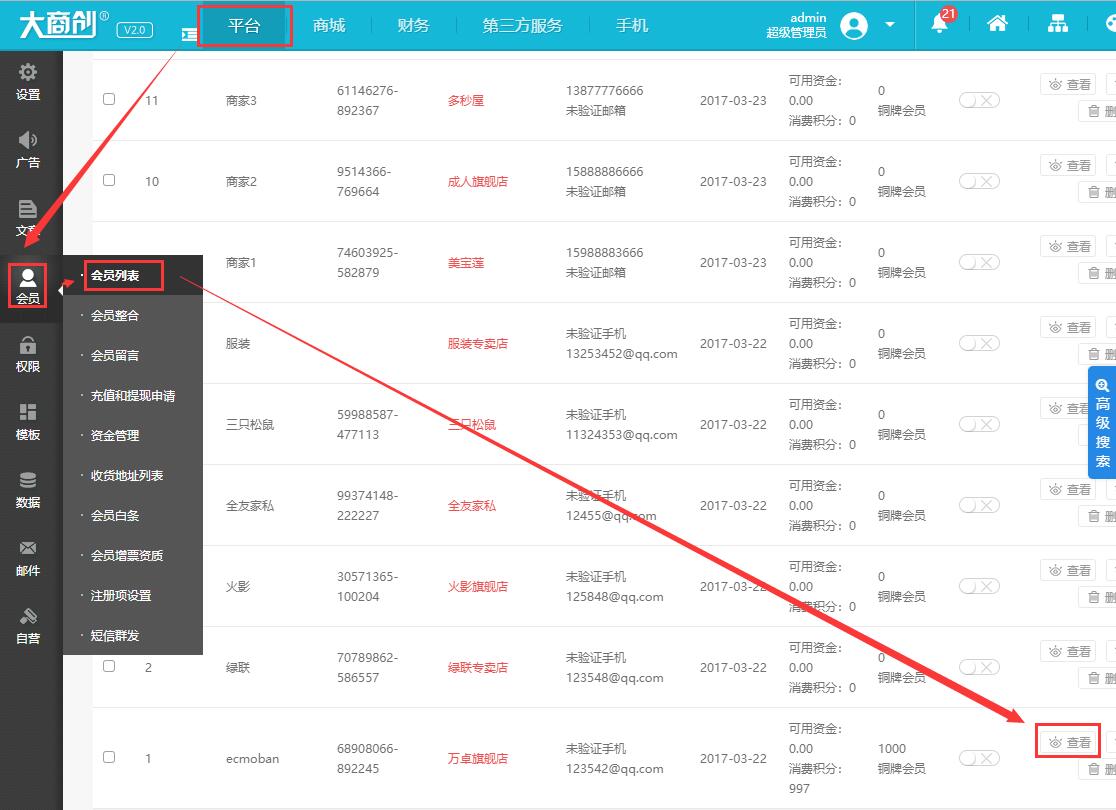

本文介绍如何修改或重置大商创会员的密码,具体步骤如下1、首先我们来到会员的列表页面,依次单击【平台】→【会员】→【会员列表】,比如我们需要修改“ecmoban”这个会员,我们再单击【查看】2、在【编辑会员账号】页...