transform以及广告计费日志实时黑名单过滤案例实战

transform操作,应用在DStream上时,可以用于执行任意的RDD到RDD的转换操作。它可以用于实现,DStream API中所没有提供的操作。比如说,DStream API中,并没有提供将一个DStream中的每个batch,与一个特定的RDD进行j...

transform操作,应用在DStream上时,可以用于执行任意的RDD到RDD的转换操作。它可以用于实现,DStream API中所没有提供的操作。比如说,DStream API中,并没有提供将一个DStream中的每个batch,与一个特定的RDD进行j...

updateStateByKey操作,可以让我们为每个key维护一份state,并持续不断的更新该state。首先,要定义一个state,可以是任意的数据类型;其次,要定义state更新函数——指定一个函数如何使用之前的state和新值来更新stat...

TransformationMeaningmap对传入的每个元素,返回一个新的元素flatMap对传入的每个元素,返回一个或多个元素filter对传入的元素返回true或false,返回的false的元素被过滤掉union将两个DStream进行合并count返回元素...

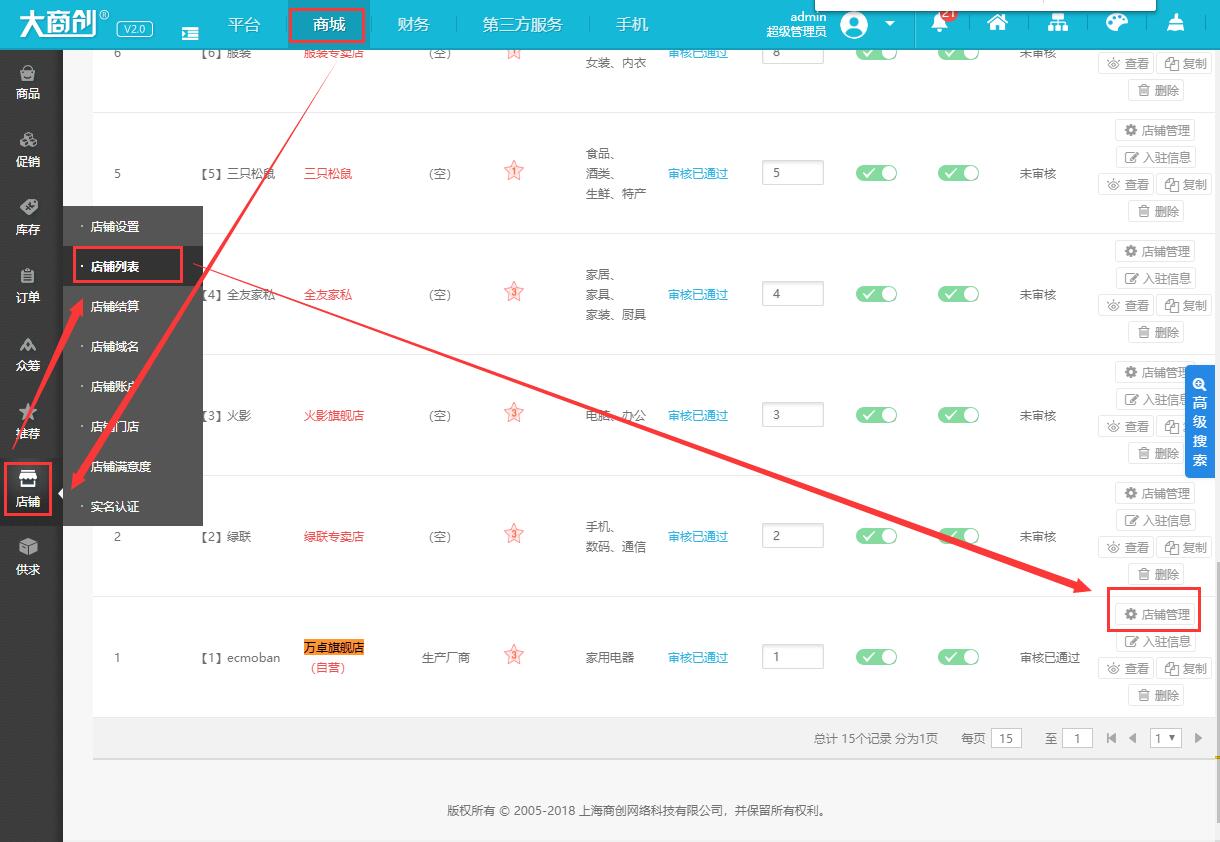

本文介绍如何修改或重置大商创商家的登录密码,实际运营过程中,忘记商家后台的用户名和密码也是非常常见的,具体步骤如下1、首先,登录大商创的后台,依次点击【商城】→【店铺】→【店铺列表】,我们以修改“万卓旗舰...

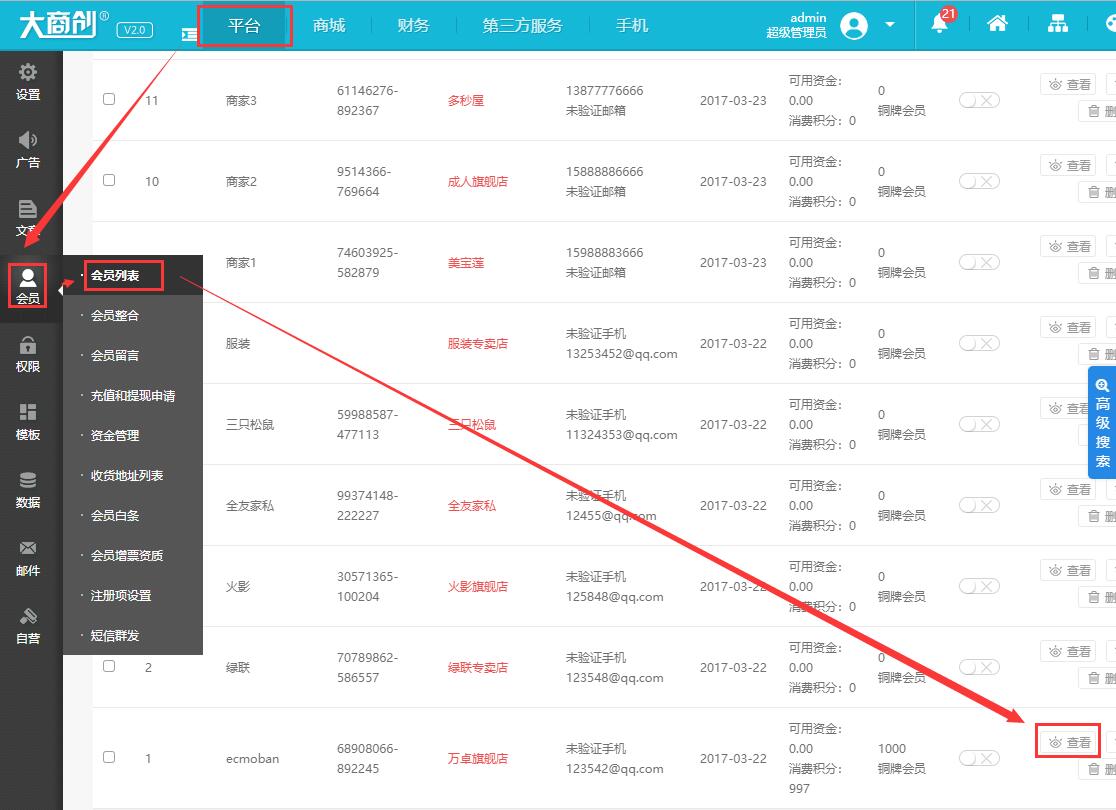

本文介绍如何修改或重置大商创会员的密码,具体步骤如下1、首先我们来到会员的列表页面,依次单击【平台】→【会员】→【会员列表】,比如我们需要修改“ecmoban”这个会员,我们再单击【查看】2、在【编辑会员账号】页...

基于Direct的方式这种新的不基于Receiver的直接方式,是在Spark 1.3中引入的,从而能够确保更加健壮的机制。替代掉使用Receiver来接收数据后,这种方式会周期性地查询Kafka,来获得每个topic+partition的最新的offse...

基于Receiver的方式这种方式使用Receiver来获取数据。Receiver是使用Kafka的高层次Consumer API来实现的。receiver从Kafka中获取的数据都是存储在Spark Executor的内存中的,然后Spark Streaming启动的job会去处理那...

Socket:之前的wordcount例子,已经演示过了,StreamingContext.socketTextStream()HDFS文件基于HDFS文件的实时计算,其实就是,监控一个HDFS目录,只要其中有新文件出现,就实时处理。相当于处理实时的文件流。stre...

输入DStream代表了来自数据源的输入数据流。在之前的wordcount例子中,lines就是一个输入DStream(JavaReceiverInputDStream),代表了从netcat(nc)服务接收到的数据流。除了文件数据流之外,所有的输入DStream都...

有两种创建StreamingContext的方式:val conf = new SparkConf().setAppName(appName).setMaster(master);val ssc = new StreamingContext(conf, Seconds(1));Streami...

安装nc工具:yum install nc如果遇到错误nc: Protocol not available,是因为版本太高删除原来的ncyum erase nc下载较低版本的nc的.rpm文件wget http://vault.centos.org/6.3/os/i386/Packages/nc-1....

大数据实时计算介绍Spark Streaming,其实就是一种Spark提供的,对于大数据,进行实时计算的一种框架。它的底层,其实,也是基于我们之前讲解的Spark Core的。基本的计算模型,还是基于内存的大数据实时计算模型。而...

新闻网站关键指标离线统计背景新闻网站版块新闻页面新用户注册用户跳出需求分析每天每个页面的PV:PV是Page View,是指一个页面被所有用户访问次数的总和,页面被访问一次就被记录1次PV每天每个页面的UV:UV是User V...

Spark SQL CLI是一个很方便的工具,可以用来在本地模式下运行Hive的元数据服务,并且通过命令行执行针对Hive的SQL查询。但是要注意的是,Spark SQL CLI是不能与Thrift JDBC server进行通信的。如果要启动Spark SQL C...

Spark SQL的Thrift JDBC/ODBC server是基于Hive 0.13的HiveServer2实现的。这个服务启动之后,最主要的功能就是可以让我们通过Java JDBC来以编程的方式调用Spark SQL。此外,在启动该服务之后,可以通过Spark或Hive...

Flume是Cloudera提供的一个高可用的,高可靠的,分布式的海量日志采集、聚合和传输的系统,Flume支持在日志系统中定制各类数据发送方,用于收集数据;同时,Flume提供对数据进行简单处理,并写到各种数据接受方(可...

掌握了源码编译,就具备了对Spark进行二次开发的基本条件了!如果你要修改Spark源码,进行二次开发,那么首先就得从官网下载指定版本的源码,然后倒入你的ide开发环境,进行源码的修改;接着修改完了,你希望能够将...

Spark安装下载Spark-bin-hadoop将下载的Spark-bin-hadoop包解压缩到/usr/local文件夹下修改Spark-bin-hadoop文件夹名字为spark配置环境变量sh vi .bashrc export SPARK_HOME=/usr/local/spark export PATH=$PATH:...

Kafka是一种高吞吐量的分布式发布订阅消息系统,它可以处理消费者规模的网站中的所有动作流数据。 这种动作(网页浏览,搜索和其他用户的行动)是在现代网络上的许多社会功能的一个关键因素。 这些数据通常是由于吞...

ZooKeeper集群搭建搭建Zookeeper的目的是为了后面搭建kafka,搭建kafka的目的是后面的spark streaming要进行实时计算,最常用的场景就是让Spark streaming接通kafka来做实时计算的实验。下载安装ZooKeeper下载ZooKee...